Contenuti

332 Totale visite, 2 Visite oggi

I file “robots.txt” e “.htaccess” sono entrambi strumenti utili per la gestione di siti web e per il controllo dell’accesso ai contenuti. Ecco come gestirli correttamente:

Il file “robots.txt” è un file di testo che viene inserito nella root del sito web e fornisce istruzioni ai motori di ricerca sui contenuti del sito che possono o non possono essere indicizzati. Per gestire correttamente il file “robots.txt” è necessario:

- Creare un file di testo con il nome “robots.txt”.

- Definire le regole per il controllo dei motori di ricerca. Ad esempio, è possibile impedire l’indicizzazione di una cartella specifica o di una pagina particolare.

- Verificare periodicamente il contenuto del file e apportare eventuali modifiche in base alle esigenze del sito.

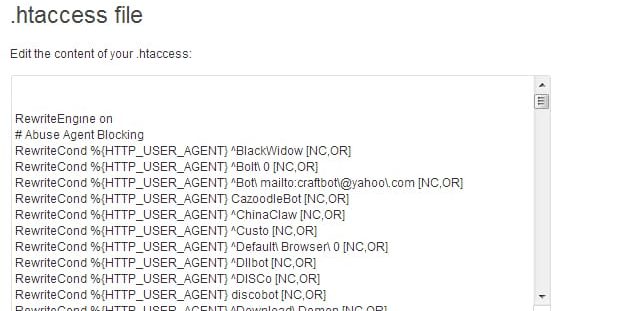

Il file “.htaccess” è un file di configurazione utilizzato per gestire il server web. Esso consente di definire regole per la sicurezza, la gestione degli errori e il reindirizzamento delle pagine. Per gestire correttamente il file “.htaccess” è necessario:

- Creare un file di testo con il nome “.htaccess”.

- Definire le regole per la gestione del server web, come la definizione delle regole di sicurezza, la configurazione degli errori e il reindirizzamento delle pagine.

- Verificare periodicamente il contenuto del file e apportare eventuali modifiche in base alle esigenze del sito.

In entrambi i casi, è importante fare attenzione a non commettere errori nella definizione delle regole, poiché questo potrebbe causare problemi di accesso al sito o di indicizzazione dei contenuti da parte dei motori di ricerca. Inoltre, è importante fare regolari backup dei file per evitare la perdita di dati in caso di problemi tecnici.

Come Ottimizzare robots.txt e .htaccess per il SEO

Il file “robots.txt” e il file “.htaccess” possono essere utilizzati per ottimizzare l’aspetto SEO di un sito web, in particolare per controllare l’indicizzazione dei contenuti e la gestione degli URL. Ecco alcune linee guida generali per ottimizzare questi file:

- File robots.txt

- Utilizzare il file robots.txt per indicare ai motori di ricerca quali pagine devono essere indicizzate e quali no. Ad esempio, se ci sono pagine che non dovrebbero essere indicizzate, come quelle di login o quelle di amministrazione, è possibile impedirne l’indicizzazione utilizzando “Disallow”.

- Utilizzare “User-agent” per specificare quali motori di ricerca devono essere indirizzati. Ad esempio, se si desidera consentire solo a Google di accedere al sito, utilizzare “User-agent: Google” seguito da “Allow: /” per consentire l’accesso a tutto il sito.

- Assicurarsi che il file robots.txt sia accessibile a tutti i motori di ricerca, evitando di bloccarlo tramite “Disallow: /robots.txt”.

- File .htaccess

- Utilizzare il file .htaccess per impostare reindirizzamenti permanenti da pagine obsolete a pagine nuove o per ridirezionare gli URL dinamici a URL statici, creando così URL SEO-friendly.

- Impostare il caching dei file per migliorare le prestazioni del sito. Ad esempio, impostare “ExpiresByType image/png “access plus 1 month”” per conservare le immagini per un mese, riducendo così il tempo di caricamento della pagina.

- Utilizzare la compressione gzip per ridurre la dimensione dei file e migliorare le prestazioni del sito. Ad esempio, impostare “SetOutputFilter DEFLATE” per abilitare la compressione gzip sui file HTML, CSS e JS.

- Utilizzare “Header set X-Robots-Tag” per controllare l’indicizzazione dei contenuti. Ad esempio, impostare “Header set X-Robots-Tag “noindex, nofollow”” per impedire l’indicizzazione di una determinata pagina o di una determinata area del sito.

In sintesi, il file robots.txt e il file .htaccess possono essere utilizzati per ottimizzare l’aspetto SEO di un sito web, controllando l’indicizzazione dei contenuti e la gestione degli URL. Tuttavia, è importante fare attenzione a non commettere errori e a verificare regolarmente il funzionamento di queste configurazioni per assicurarsi che non causino problemi tecnici.

Cos’è il file robots.txt

Il file “robots.txt” è un file di testo che viene utilizzato dai motori di ricerca per determinare quali pagine del sito web devono essere indicizzate e quali no. Il file viene posizionato nella root del sito web e contiene informazioni sulle pagine che non devono essere indicizzate dai motori di ricerca.

Il file robots.txt è stato introdotto nel 1994 come parte del protocollo Robots Exclusion Standard, che definisce un insieme di linee guida per il controllo degli spider dei motori di ricerca. Il file consente ai proprietari del sito web di escludere pagine specifiche dalla ricerca dei motori di ricerca, evitando che i risultati di ricerca restituiscano pagine di bassa qualità o pagine duplicati.

Il file robots.txt viene letto dai motori di ricerca ogni volta che questi visitano il sito web. Se un motore di ricerca trova il file robots.txt, legge le istruzioni contenute al suo interno e le utilizza per decidere quali pagine del sito web devono essere indicizzate.

È importante notare che il file robots.txt non impedisce l’accesso alle pagine del sito web, ma semplicemente ne impedisce l’indicizzazione da parte dei motori di ricerca. Ciò significa che il file non può essere utilizzato per proteggere i dati sensibili, ma solo per gestire l’indicizzazione dei contenuti del sito web.

In sintesi, il file robots.txt è un file di testo utilizzato per gestire l’indicizzazione dei contenuti del sito web da parte dei motori di ricerca. Consentendo ai proprietari del sito di controllare quali pagine devono essere indicizzate e quali no.

Cos’è il file .htaccess

Il file “.htaccess” (pronunciato “acceso-ht” o “h-t-access”) è un file di configurazione che viene utilizzato sui server web Apache per controllare il comportamento del server, definire le regole di reindirizzamento, la gestione delle autorizzazioni, la compressione dei file e molte altre funzionalità avanzate.

Il file .htaccess è una parte importante del sistema di configurazione di Apache, in quanto consente ai proprietari del sito di personalizzare l’esperienza del visitatore e migliorare le prestazioni del sito stesso. Il file è posizionato nella root del sito web e contiene le istruzioni per il server Apache sulle opzioni di configurazione per quel particolare sito.

Il file .htaccess è scritto in linguaggio Apache mod_rewrite, che consente di creare regole di reindirizzamento dinamico degli URL e di gestione delle autorizzazioni. Le regole di reindirizzamento permettono di creare URL amichevoli ai motori di ricerca, risolvere i problemi di contenuto duplicato, gestire il caching e migliorare la sicurezza del sito. Le istruzioni di gestione delle autorizzazioni, invece, consentono di limitare l’accesso alle pagine del sito solo a determinati utenti.

È importante notare che non tutti i server web utilizzano il file .htaccess per la configurazione. In particolare, alcuni server web come Nginx o Microsoft IIS utilizzano un sistema di configurazione diverso, che richiede una configurazione diretta del server.

In sintesi, il file .htaccess è un file di configurazione utilizzato sui server web Apache per controllare il comportamento del server e migliorare le funzionalità avanzate del sito web. Consente ai proprietari del sito di personalizzare l’esperienza del visitatore e migliorare le prestazioni del sito stesso.

Esempio di file .htaccess

# Attivazione del modulo rewrite

RewriteEngine On

# Redirect da http a https

RewriteCond %{HTTPS} off

RewriteRule ^(.*)$ https://%{HTTP_HOST}%{REQUEST_URI} [L,R=301]

# Impostazione del caching dei file

<IfModule mod_expires.c>

ExpiresActive On

ExpiresDefault “access plus 1 month”

ExpiresByType text/css “access plus 1 year”

ExpiresByType application/javascript “access plus 1 year”

ExpiresByType image/gif “access plus 1 year”

ExpiresByType image/png “access plus 1 year”

ExpiresByType image/jpg “access plus 1 year”

</IfModule>

# Limitazione dell’accesso alle directory

<Directory “/path/to/directory”>

Options -Indexes

AllowOverride None

Order deny,allow

Deny from all

</Directory>

In questo esempio, il file .htaccess abilita il modulo rewrite di Apache per la gestione delle regole di reindirizzamento degli URL e poi definisce alcune regole:

- La prima regola di reindirizzamento controlla se la connessione al sito web avviene tramite HTTPS; se non lo è, il server reindirizza automaticamente il visitatore verso la versione HTTPS del sito.

- La seconda regola imposta le opzioni di caching per i diversi tipi di file, consentendo di salvare in cache file come immagini, fogli di stile e script per periodi di tempo specifici.

- La terza regola limita l’accesso alle directory, impedendo agli utenti di visualizzare l’elenco dei file contenuti in queste cartelle e negando l’accesso completo alle stesse.

Questo è solo un esempio di come potrebbe apparire un file .htaccess, le regole e le opzioni dipendono dalle esigenze specifiche del sito web.

Review Come gestire i file robots.txt e .htaccess.

You must be logged in to post a review.